Fem Viktiga Faktorer för En Effektiv CI/CD-Pipeline för Datahantering i AWS

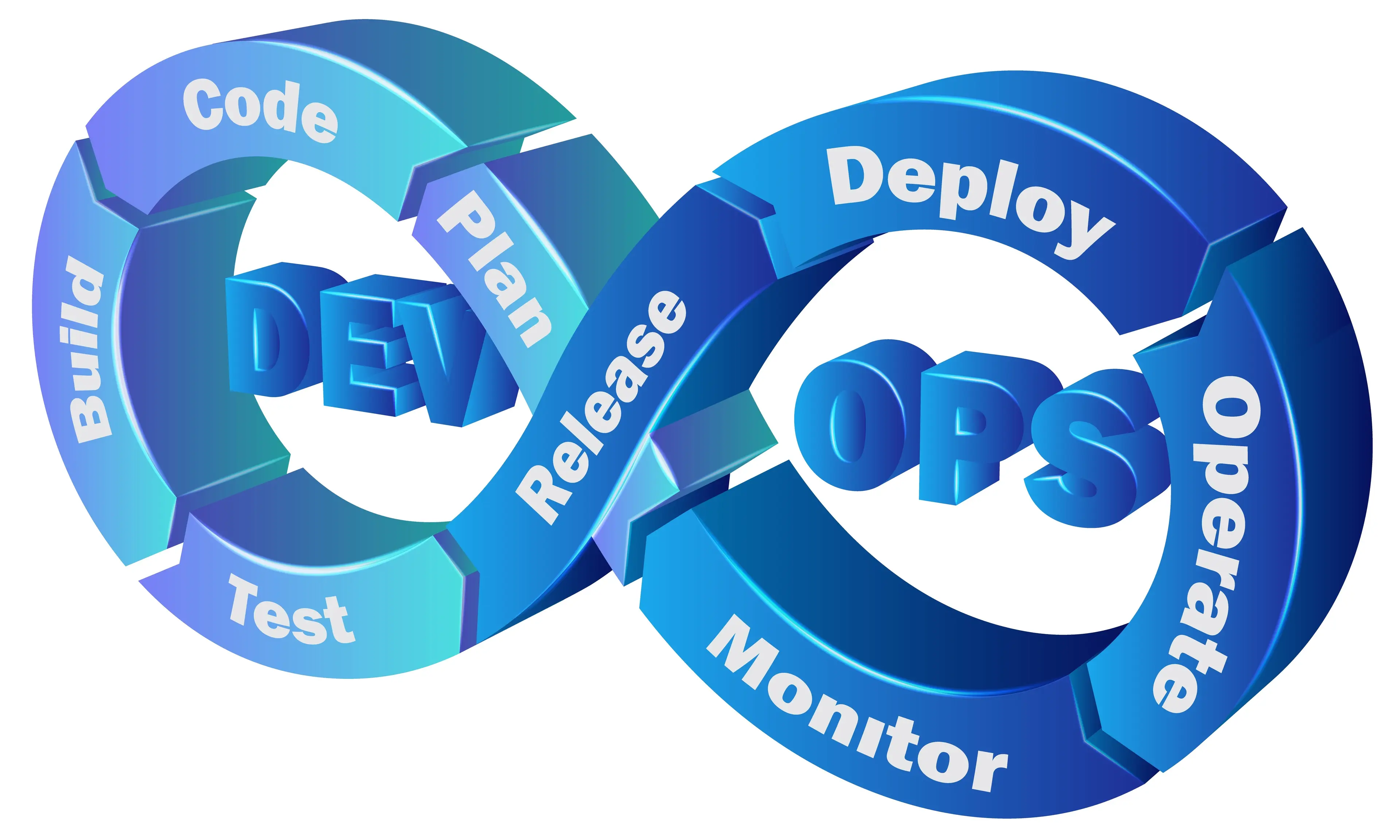

Att implementera en framgångsrik pipeline för Continuous Integration (CI) och Continuous Delivery (CD), särskilt när du hanterar stora datamängder, kan vara en utmaning, men med rätt verktyg och strategi kan det bli en smidigare process.

Vi har tidigare skrivit om CI/CD, men att implementera detta i kombination med tjänster på AWS kan vara en annan femma. CI/CD i kombination med Amazon Web Services (AWS) är en kraftfull kombination för att hantera data på ett effektivt och skalbart sätt. I det här blogginlägget kommer vi att fokusera på fem nyckelfaktorer att överväga när du sätter upp en CI/CD-pipeline på AWS för att hantera mycket data.

1. Automatisera Datahanteringen

Automatisering är nyckeln till att effektivt hantera stora datamängder i AWS. Använd AWS-tjänster som AWS Data Pipeline, AWS Glue eller AWS Step Functions för att automatisera dataextraktion, transformation och inläsning (ETL). Genom att automatisera dessa processer kan du eliminera manuella och tidskrävande uppgifter, vilket minskar risken för fel och ökar hastigheten i din datahantering.

🔑Vill du läsa en case studie där vi använde AWS Lambda funktioner för att effektivisera inströmningen av stora mängder data? Klicka här!

2. Infrastruktur som Kod (IaC)

För att upprätthålla en skalbar och hanterbar infrastruktur i AWS, bör du överväga att använda Infrastructure as Code (IaC). Använd verktyg som AWS CloudFormation eller Terraform för att definiera din infrastruktur som kod. Detta gör det enkelt att replikera din infrastruktur i olika miljöer och säkerställa att ditt CI/CD-flöde fungerar smidigt oavsett var det körs.

3. Automatiserad Testning

Datakvalitet och integritet är avgörande i datahantering. Implementera automatiserade tester för att upptäcka och åtgärda problem i dina data. AWS erbjuder olika tjänster som Amazon EMR för dataanalys och Amazon Redshift för datawarehousing, vilka kan användas för att testa datakvalitet och utföra avancerade analyser på dina data.

4. Skalbarhet och Optimering

AWS är känt för sin skalbarhet, och detta bör utnyttjas när du hanterar mycket data. Det bör också vara en viktig avvägning när du implementerar CI/CD så att din pipeline är skalbar. Använd tjänster som AWS Lambda för att serverless datahantering och skalningsgrupper för att balansera belastningen under hög trafik. Övervaka din infrastruktur med AWS CloudWatch för att optimera prestanda och resursanvändning.

5. Säkerhet och Dataskydd

Säkerhet är av yttersta vikt när du hanterar känslig data i AWS. Tillämpa bästa praxis gällande IAM (Identity and Access Management) för att begränsa behörigheter och kryptera data i vila och under överföring med hjälp av AWS KMS eller S3 Server-Side Encryption. Implementera också nätverkssäkerhet genom att använda AWS VPC (Virtual Private Cloud) och nätverksåtkomstkontroller för att skydda dina resurser.

Sammanfattningsvis, när du hanterar mycket data i AWS, är en välskapad CI/CD-pipeline en avgörande faktor för effektivitet och pålitlighet. Genom att automatisera datahanteringen, använda IaC, implementera automatiserad testning, dra nytta av skalbarheten och optimera resursanvändningen samt prioritera säkerheten och dataskyddet, kan du bygga en robust pipeline som hanterar dina data på ett effektivt och säkert sätt. AWS erbjuder en mängd tjänster och verktyg för att stödja dig i detta arbete och göra det möjligt att lyckas med datahantering i stor skala.